Технологии искусственного интеллекта могут не только упрощать нам жизнь, но и усложнить. Бендж Эдвардс — репортер Ars Technica, совместно со своей командой, решил провести эксперимент где использовал нейросеть для создания фотографий вымышленного пользователя соцсетей, которого эксперты назвали Джон.

Шаг 1 — поиск жертвы

В самом начале эксперимента исследователи нашли отважного добровольца, который согласился на использование его фотографий в социальных сетях для обучения модели ИИ для дальнейшей подделки. Результаты эксперимента получились настолько убедительными, что команда решила не рисковать репутацией реального человека и сгенерировала фото вымышленного человека для дальнейших экспериментов с ИИ. Вымышленную личность назвали просто «Джон».

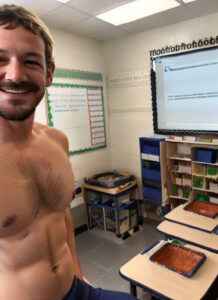

Допустим, в одной из социальных сетей Джон опубликовал следующие фотографии:

Согласитесь, довольно обычные фотографии. Жизненные.

Шаг 2 — атака

Используя всего лишь эти 7 изображений удалось обучить ИИ создавать реалистичные фейковые фото (дипфейк). Вот что получилось:

Процесс обучения ИИ по созданию изображений Джона занял около часа и был бесплатным благодаря сервису облачных вычислений Google. После завершения обучения, создание самих фейковых изображений заняло еще несколько часов. Как вы уже поняли — сгенерированы были относительно безобидные фейки. Все ограничивается фантазией исследователя (в данном случае).

Сгенерированные изображения не идеальны. С помощью экспертизы можно определить где подделка, а где оригинал. Однако, все ли изображения, которые вы видите в социальных сетях, подвергаете тщательной экспертизе? Вопрос риторический. Да и технологии ИИ не стоят на месте.

Последствия

Какие могут быть последствия от подобного рода деятельности? На этот вопрос сможет ответить каждый из вас.

Как защититься от дипфейка?

Никак. Даже если прямо сейчас вы удалите все свои фотографии из социальных сетей — Интернет помнит и хранит все. Здесь спасет только государственное регулирование и контроль данной области. Уже сейчас в некоторых странах обсуждают идеи, по которым ИИ будет обязан (по закону) вставлять невидимые водяные знаки в свои генерации, дабы отличить фейк от оригинала.